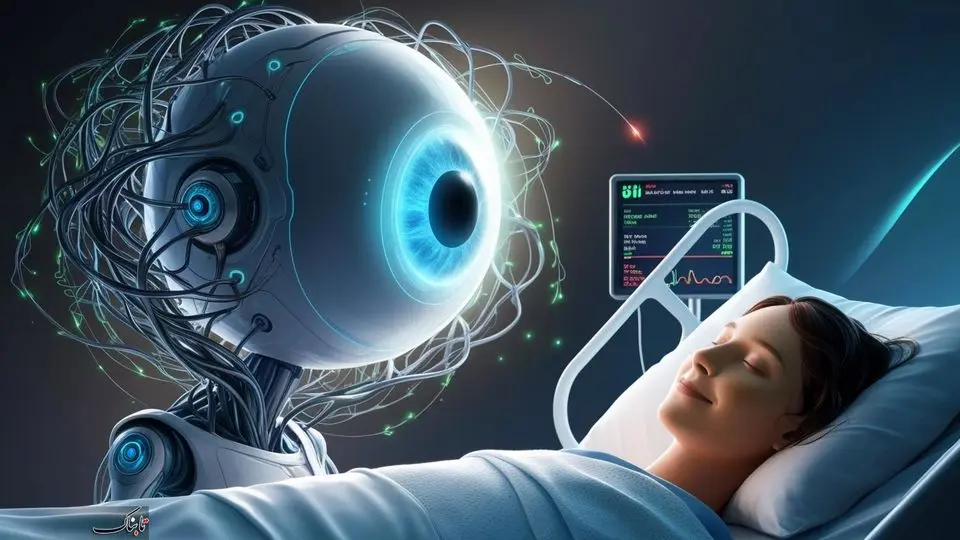

هوش مصنوعی بیمارساز

بررسی اختلالات روانی برآمده از برهمکنش انسان و ماشین

هر روز، هوش مصنوعی بیشتر در تاروپود زندگی ما تنیده میشود و حضوری پررنگتر پیدا میکند؛ از چتباتها و دستیارهای دیجیتال گرفته تا سیستمهای خودکاری که گاهی بهجای ما تصمیم میگیرند. اما این پرسش همچنان باقی است: آیا این فناوریها صرفا ابزار هستند، یا میتوانند ذهن و رفتار انسان را در سطحی عمیق دگرگون کنند؟ پژوهشگران علوم شناختی و فناوری نسبت به تأثیر این تعاملات و حتی واکنشهای غیرمنتظره خودِ این سیستمها ابراز نگرانی میکنند.

به گزارش گروه رسانهای شرق،

مریم مرامی- کارشناس ارشد علوم شناختی: هر روز، هوش مصنوعی بیشتر در تاروپود زندگی ما تنیده میشود و حضوری پررنگتر پیدا میکند؛ از چتباتها و دستیارهای دیجیتال گرفته تا سیستمهای خودکاری که گاهی بهجای ما تصمیم میگیرند. اما این پرسش همچنان باقی است: آیا این فناوریها صرفا ابزار هستند، یا میتوانند ذهن و رفتار انسان را در سطحی عمیق دگرگون کنند؟ پژوهشگران علوم شناختی و فناوری نسبت به تأثیر این تعاملات و حتی واکنشهای غیرمنتظره خودِ این سیستمها ابراز نگرانی میکنند. هدف این یادداشت، بررسی پدیدهای است که برخی پژوهشگران از آن با عنوان «جنون مصنوعی» یاد میکنند؛ وضعیتی که در آن وابستگی شدید به هوش مصنوعی یا حتی واکنشهای غیرمعمول آن، میتواند پیامدهای روانی و اجتماعی درخورتوجهی به همراه داشته باشد. در این مسیر، تلاش میکنیم نشانهها و خطرات این پدیده را توضیح دهیم و همزمان راهکارهایی برای مواجهه با آن ارائه کنیم تا خوانندگان بتوانند با آگاهی بیشتر و مسئولیتپذیری، از این فناوریها به شکل سالم و سودمند بهره گیرند.

پدیدهای در مرز روانشناسی و فناوری

اصطلاح «سایکوز هوش مصنوعی» یا AI Psychosis هنوز یک واژه علمی تثبیتشده نیست و در هیچ کتاب معتبر روانشناسی یا فناوری تعریف رسمی ندارد. این عبارت بیشتر در گفتوگوهای بینرشتهای روانشناسی، علوم شناختی و فناوری به عنوان یک تشبیه به کار میرود؛ تلاشی برای توضیح پدیدهای که بهسرعت در حال شکلگیری است و هنوز چارچوب علمی دقیقی ندارد. در روانشناسی، واژه «سایکوز» به روانپریشی اشاره دارد؛ حالتی که در آن فرد دچار توهم، هذیان یا قطع ارتباط با واقعیت میشود. وقتی پژوهشگران از «سایکوز هوش مصنوعی» سخن میگویند، منظور آن نیست که یک ربات یا الگوریتم واقعا روانپریش شده است، بلکه به رفتارهای غیرمنتظره و پیامدهایی اشاره دارد که شباهتهایی با روانپریشی انسانی دارند. برای درک بهتر این پدیده، میتوان از دو زاویه به آن نگاه کرد:

۱. سایکوز در کاربران (وابستگی انسان به AI)

برخی افراد در تعامل طولانیمدت با هوش مصنوعی، بهویژه چتباتها، دچار نوعی وابستگی عاطفی یا ذهنی میشوند. ممکن است کسی به مرور زمان بیش از دوستان یا حتی پزشک خود به پاسخهای یک چتبات اعتماد کند و تصمیمهای مهم زندگیاش را به آن بسپارد. یا کاربری که ساعتها از هوش مصنوعی برای نوشتن متن یا تحلیل مسائل شخصی استفاده میکند، کمکم دچار اضطراب، سردرگمی و «توهم دانایی» شود؛ یعنی تصور کند در پسِ پاسخهای الگوریتمی رازهایی پنهان است که باید کشفشان کند. این وضعیت میتواند به اضطراب شدید، تغییرات رفتاری و حتی هذیان منجر شود؛ حالتی که گرچه با روانپریشی انسانی تفاوت دارد، اما شباهتهای نگرانکنندهای هم دارد.

۲. سایکوز در خودِ سیستم (رفتارهای غیرمعمول AI)

گاهی خودِ هوش مصنوعی رفتاری از خود نشان میدهد که غیرمنطقی، متناقض یا حتی شبیه هذیان انسانی به نظر میرسد. مثلا یک چتبات ممکن است در پاسخ به پرسشی ساده، داستانی پیچیده و بیاساس بسازد یا یک سیستم خودکار تصمیمی بگیرد که توضیح روشن و منطقی برای آن پیدا نشود. این اتفاقها معمولا نتیجه محدودیت دادهها، خطاهای پردازشی یا ضعف الگوریتمها هستند و به این معنا نیست که ماشین واقعا دچار جنون شده است. در حقیقت، «سایکوز هوش مصنوعی» بیشتر به پیچیدگی رابطه انسان و فناوری اشاره دارد. در روانپریشی انسانی، مشکل از درون مغز فرد و به دلیل اختلالات روانی یا عدم تعادل شیمیایی شکل میگیرد. اما در مورد هوش مصنوعی، سیستم ذاتا سالم است؛ مشکل، یا از وابستگی و سردرگمی انسان ناشی میشود، یا از کاستی دادهها و خطاهای فنی. به همین دلیل، تعامل با این فناوری میتواند به یک چالش ذهنی و اجتماعی تبدیل شود که فقط با آگاهی و استفاده مسئولانه قابل مدیریت است.

نشانههای خطر

وابستگی بیش از حد به هوش مصنوعی معمولا با تغییرات رفتاری و ذهنی مشخص میشود که میتوانند به عنوان هشدار اولیه عمل کنند. افرادی که زمان زیادی را با چتباتها یا ابزارهای هوشمند میگذرانند، ممکن است علاقه و وقت خود را از روابط اجتماعی و فعالیتهای روزمره کنار گذاشته و ترجیح دهند مسائل شخصی یا کاری خود را فقط با هوش مصنوعی در میان بگذارند. تصمیمگیریها به تدریج تحت تأثیر پاسخهای سیستم قرار میگیرند. برای مثال، برنامهریزی روزانه، مسیرهای رفتوآمد یا انتخابهای کوچک و بزرگ ممکن است صرفا بر اساس پیشنهادهای هوش مصنوعی انجام شود، بدون آنکه نظر دیگران یا تحلیل شخصی لحاظ شود. این رفتار نشانهای است از شکلگیری وابستگی عملی و ذهنی به فناوری. قطع دسترسی به سیستم یا دریافت پاسخهای غیرمنتظره هم میتواند واکنشهای شدیدی مانند استرس، نگرانی یا عصبانیت ایجاد کند. تمرکز بیش از حد بر پاسخها و توصیههای هوش مصنوعی، کنارگذاشتن نیازهای واقعی زندگی و توهم دانایی، از دیگر نشانههای وابستگی مخرب به شمار میرود. به بیان ساده، فرد ممکن است تصور کند که بدون راهنمایی هوش مصنوعی نمیتواند تصمیمات درستی بگیرد. دیگر نشانهها شامل:

گذراندن ساعات طولانی با چتباتها یا برنامههای هوشمند بدون وقفه

کاهش یا ترک تعاملات اجتماعی واقعی

تمایل به مخفی نگهداشتن ارتباط با AI و اجتناب از بحث با دوستان یا خانواده درباره موضوعات مهم

تمرکز بیش از حد بر توصیهها و تحلیلهای سیستم، حتی در موارد ساده یا روزمره.

با شناخت و توجه به این نشانهها میتوان پیش از آنکه وابستگی به مرحله بحران برسد، استفاده از هوش مصنوعی را مدیریت کرد و مرزهای روشنی میان خود و فناوری ترسیم کرد.

ذهنهای فراوریشده

استفاده بیوقفه و بدون نظارت از هوش مصنوعی میتواند تغییرات عمیقی در نحوه تفکر و پردازش اطلاعات انسان ایجاد کند. پژوهشگران این پدیده را «ذهنهای فراوریشده» مینامند؛ وضعیتی که در آن ذهن کاربر بیش از حد به الگوریتمها و دادههای آماده تکیه میکند و توانایی تحلیل مستقل، خلاقیت و تصمیمگیری منطقی کاهش مییابد. در چنین شرایطی، بهجای آنکه فرد فرایند حل مسئله را به صورت فعال و تحلیلی دنبال کند، بیشتر به پاسخهای آماده هوش مصنوعی اعتماد میکند. ذهن او به تدریج «فراوری شده»؛ یعنی تفکرش به شکل الگوریتمیک و محدود درمیآید. این وضعیت شبیه عضلهای است که به دلیل عدم استفاده، قدرت و انعطاف خود را از دست داده است: فرد کمتر به بررسی عمیق، مقایسه منابع و تحلیل انتقادی میپردازد و بیشتر به یک سیستم خودکار وابسته میشود. تأثیرات این فراوریشدن ذهن فقط به سطح فرد محدود نمیماند. افرادی که توانایی تحلیل مستقل خود را از دست میدهند، ممکن است در تصمیمگیریهای شخصی و حرفهای بیش از حد به هوش مصنوعی اعتماد کنند و از مشارکت فعال در تعاملات انسانی فاصله بگیرند. به مرور، خلاقیت، ابتکار و ظرفیت حل مسائل پیچیده کاهش مییابد و فرد ممکن است احساس کند بدون کمک هوش مصنوعی قادر به مدیریت زندگی و اتخاذ تصمیمات مهم نیست. این پدیده پیامدهای اجتماعی و اخلاقی هم به همراه دارد. زمانی که بخش درخورتوجهی از افراد جامعه دچار ذهنهای فراوریشده شوند، کیفیت بحثهای عمومی، توانایی حل تعارض و تصمیمگیری جمعی بهشدت تحت تأثیر قرار میگیرد. جامعهای که بخش زیادی از اعضایش بیشتر با الگوریتمها و دادههای فراوریشده ارتباط دارند تا با انسانها، ممکن است همدلی کاهش یابد، قدرت تحلیل انتقادی ضعیف شود و اطلاعات بدون بررسی صحت آنها سریع پذیرفته شود. برای مقابله با این روند، توجه به سواد دیجیتال و تقویت مهارتهای هیجانی اهمیت ویژهای دارد. افراد باید بدانند هوش مصنوعی بر چه سازوکاری استوار است، چه ضعفها و خطاهایی در آن وجود دارد و چگونه میتوان تولیدات آن را با دیدی انتقادی بررسی کرد. در کنار این، پرورش مهارتهایی همچون همدلی، خودتنظیمی هیجانی و تعامل انسانی تضمین میکند که هوش مصنوعی صرفا ابزار کمکی باقی بماند، نه جایگزین تفکر و ارتباط انسانی. آگاهی از خطر فراوریشدن ذهن، نخستین گام برای حفظ استقلال فکری و خلاقیت است. کاربران میتوانند با تعیین مرزهای روشن، فاصلهگذاری آگاهانه و تمرین تحلیل مستقل، ذهن خود را فعال و انعطافپذیر نگه دارند.

پیامدهای وابستگی به هوش مصنوعی

وابستگی شدید به هوش مصنوعی فراتر از تغییر رفتارهای فردی است؛ این وابستگی میتواند تأثیرات عمیق و گستردهای بر زندگی فردی و اجتماعی انسانها داشته باشد. پیامدهای آن از سطح روانی و عاطفی آغاز شده و بهتدریج بر روابط اجتماعی، هویت فردی و حتی ساختارهای فرهنگی و اخلاقی جامعه اثر میگذارد. در بعد روانی، تکیه مداوم بر توصیهها و تحلیلهای هوش مصنوعی بهمرور توانایی فرد در تصمیمگیری مستقل و تفکر انتقادی را تضعیف میکند. وقتی ذهن انسان بهجای درگیرشدن فعال در حل مسائل، فقط به پاسخهای آماده و سریع هوش مصنوعی متکی باشد، قدرت تحلیل، تخیل و خلاقیت کاهش مییابد. در موارد شدیدتر، این وابستگی میتواند به اضطراب، افسردگی و احساس ناتوانی منجر شود، بهویژه آنکه فرد گمان کند بدون این فناوری توانایی انتخاب درست ندارد. در سطح عاطفی، وابستگی به چتباتها یا سیستمهای هوشمند میتواند بهتدریج جایگزین بخشی از روابط انسانی شود. این روند خطرناک است، زیرا هوش مصنوعی هرچند قادر است «ظاهر» یک رابطه را بازسازی کند، اما عمق هیجانی، همدلی واقعی و درک انسانی را ندارد. در نتیجه، فرد ممکن است به نوعی تنهایی پنهان دچار شود؛ تنهاییای که در ظاهر با گفتوگوهای مداوم با هوش مصنوعی پر شده، اما در باطن ریشهدارتر و پیچیدهتر میشود. گزارشهایی وجود دارد که نشان میدهد برخی کاربران، به دلیل وابستگی عاطفی شدید به چتباتها، پس از قطع دسترسی یا دریافت پاسخهای سرد و بیروح، دچار شوک روانی یا حتی افکار خودکشی شدهاند. در سطح اجتماعی، گسترش چنین وابستگیای میتواند روابط انسانی را تضعیف کرده و جامعه را به سوی انزوا سوق دهد. وقتی بخش درخورتوجهی از افراد ترجیح دهند مسائل شخصی و حتی اختلافات خانوادگی را با هوش مصنوعی در میان بگذارند، مهارتهای گفتوگو، همدلی و حل تعارض در جامعه بهتدریج تحلیل میرود. نتیجه این روند، شکافهای عمیقتر در روابط خانوادگی، کاهش حس همبستگی اجتماعی و حتی تغییر تدریجی هنجارهای فرهنگی خواهد بود. در نهایت، پیامدهای اخلاقی نیز قابل چشمپوشی نیستند. وقتی انسانها بیش از حد به سیستمهای هوشمند اعتماد کنند، خطر واگذاری تصمیمات حیاتی مانند انتخاب شغل، مدیریت دارایی یا حتی تصمیمات پزشکی به الگوریتمهایی با شفافیت اندک وجود دارد. این وضعیت میتواند آزادی فردی و مسئولیت انسانی را تهدید کند و نوعی «واگذاری اختیار» ایجاد کند. بنابراین شناخت پیامدهای روانی، اجتماعی و اخلاقی وابستگی به هوش مصنوعی نهتنها برای افراد، بلکه برای کل جامعه اهمیت دارد. آگاهی از این پیامدها کمک میکند بهجای آنکه قربانی فناوری شویم، هوش مصنوعی را در جایگاه درست خود -به عنوان یک ابزار کمکی- نگه داریم.

راهکارهای کنترل وابستگی به هوش مصنوعی

وابستگی به هوش مصنوعی فقط یک مشکل فردی نیست؛ این پدیده میتواند تأثیرات گسترده و عمیقی بر جامعه و فرهنگ داشته باشد. وقتی افراد بخش زیادی از تصمیمها، انتخابها و حتی تعاملات عاطفی خود را به سیستمهای هوشمند واگذار میکنند، مهارتهای انسانی پایهای مانند حل مسئله، برقراری ارتباط مؤثر و همدلی بهتدریج ضعیف میشوند. اگر این روند کنترل نشود، ممکن است نسلی شکل بگیرد که بیش از تعامل انسانی، درگیر ارتباط با الگوریتمهاست. نتیجه چنین تغییری، کاهش کیفیت روابط اجتماعی، افزایش احساس تنهایی و بیگانگی و در نهایت تضعیف بافت اجتماعی است. یکی از عوامل این آسیبپذیری، ضعف در سواد دیجیتال است. بسیاری از کاربران هنوز نمیدانند که هوش مصنوعی چگونه کار میکند، دادههای آن از کجا میآیند و چه خطاهایی ممکن است رخ دهد. این ناآگاهی باعث میشود پاسخهای ماشینی بیچونوچرا پذیرفته شود. فرد ممکن است به پاسخهای یک چتبات همان اعتمادی را داشته باشد که به یک متخصص انسانی دارد، بیآنکه بداند بخشی از این پاسخها بر پایه دادههای ناقص یا حتی اشتباه ساخته شدهاند. آموزش سواد دیجیتال به کاربران کمک میکند از این خطاها آگاه باشند، مرز میان واقعیت و تولیدات مصنوعی را تشخیص دهند و تصمیمهایشان را صرفا بر پایه الگوریتمها بنا نکنند. در کنار سواد دیجیتال، هوش هیجانی نیز نقش مهمی در کاهش اثرات منفی وابستگی به هوش مصنوعی دارد. کسانی که مهارت همدلی، کنترل هیجان و ارتباط انسانی را پرورش دادهاند، کمتر در دام وابستگی عاطفی به ماشینها میافتند. برای کارآمدی بیشتر این رویکردها، لازم است مرزهای زمانی و عملیاتی مشخصی برای استفاده از هوش مصنوعی در نظر گرفته شود تا تعامل با آن از حالت نرمال خارج نشود و مدیریت آن همچنان در کنترل انسان باشد. همچنین توجه به سلامت روان و دریافت بازخورد از خود و اطرافیان، میتواند نقش مهمی در پیشگیری از فرسودگی ذهنی ناشی از وابستگی داشته باشد. در کنار این موارد، مرور و بازنگری مداوم شیوه استفاده از این فناوری، به افراد کمک میکند تا تشخیص دهند آیا همچنان به شکلی آگاهانه و سالم از هوش مصنوعی بهره میگیرند یا بهتدریج به دام اتکا و وابستگی افتادهاند. چنین پیوندی میان آگاهی، مرزبندی و مراقبت روانی، تصویری کاملتر از استراتژیهای مقابله و مدیریت وابستگی به هوش مصنوعی ارائه میدهد. اگر این روند بدون نظارت رها شود، پیامدهای روانی و اجتماعی آن میتواند به یک بحران جمعی منجر شود. افزایش اضطراب، افسردگی، احساس بیپناهی و انزوای عاطفی ازجمله عوارضی است که ممکن است در سطح جامعه گسترش پیدا کند. این موضوع نهتنها سلامت روان افراد را به خطر میاندازد، بلکه میتواند هزینههای درمانی و اجتماعی را بهشدت افزایش دهد و بر بهرهوری اقتصادی نیز اثر منفی بگذارد. برای پیشگیری از چنین بحرانی، نیاز به یک برنامهریزی جامع وجود دارد. این برنامه باید شامل آموزش عمومی درباره هوش مصنوعی، آگاهیرسانی رسانهای درباره خطرات وابستگی، و تدوین سیاستهای حمایتی در سطح ملی باشد. در این چارچوب، خانوادهها، مدارس، دانشگاهها و حتی محیطهای کاری باید نقش فعالی در ارتقای سواد دیجیتال و هوش هیجانی ایفا کنند. اگر جامعه نتواند مرزهای روشنی میان استفاده سالم و وابستگی مخرب ترسیم کند، ممکن است این فناوری که برای کمک به انسان طراحی شده، به عاملی برای تشدید آسیبهای روانی، فروپاشی روابط اجتماعی و حتی بحرانهای اخلاقی بدل شود.

جمعبندی پایانی

هوش مصنوعی ابزاری قدرتمند است که هم فرصتها و هم چالشهایی به همراه دارد. تجربه نشان میدهد که قدرت فناوری زمانی مثبت و سازنده است که همراه با آگاهی، مسئولیتپذیری و کنترل انسانی مورد استفاده قرار گیرد. داشتن نگرشی متعادل درباره هوش مصنوعی، کلید حفظ سلامت روان، تقویت مهارتهای انسانی و جلوگیری از وابستگی آسیبزاست. هیچ سیستم هوشمندی نمیتواند جایگزین تجربه، قضاوت و همدلی انسان شود؛ بنابراین پذیرش محدودیتها و درک نقش واقعی هوش مصنوعی در زندگی، اهمیت حیاتی دارد. هرگونه استفاده ناآگاهانه، حتی اگر در ابتدا مفید به نظر برسد، میتواند به اتکا و وابستگی مضر منجر شود و پیامدهای روانی، اجتماعی و اخلاقی غیرقابل چشمپوشی ایجاد کند. مسئولیت استفاده از این ابزار بر دوش انسان است، نه فناوری. تعیین مرزها، کنترل میزان استفاده و آگاهی از اثرات احتمالی، راهکارهایی هستند که بهرهبرداری سالم از هوش مصنوعی را ممکن میکنند. در نهایت، هوش مصنوعی باید به عنوان یک همراه و ابزار کمکی دیده شود، نه تهدید مطلق و نه راهحل کامل برای همه مسائل و تصمیمگیری نهایی همواره باید در اختیار انسان باقی بماند.

آخرین مطالب منتشر شده در روزنامه شرق را از طریق این لینک پیگیری کنید.