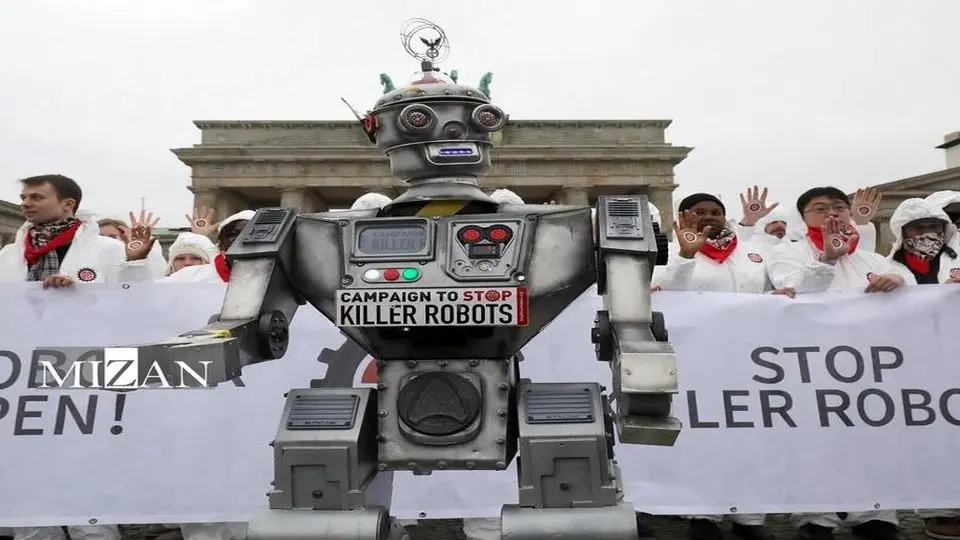

رباتهای قاتل در جنگها استفاده می شوند/ اقدام جدید مخالفان چیست؟

کارشناسان طی سالهای گذشته همواره درباره توسعه و استفاده از سیستمهای تسلیحاتی خودمختار هشدار داده و آن را ابزاری برای نقض حقوق بشر توصیف کردهاند.

به گزارش گروه رسانه ای شرق؛ گروههای حقوق بشری میگویند که بهنظر میرسد حرکت جهانی برای ممنوعیت و تنظیم قوانین درباره رباتهای قاتل درحال افزایش است؛ این موضوع از مشارکت بسیاری از کشورها در نخستین جلسه مجمع عمومی سازمان ملل درمورد سیستمهای تسلیحاتی خودمختار مشهود است.

مقامهایی از ۹۶ کشور بههمراه نمایندگانی از آژانسهای سازمان ملل، کمیته بینالمللی صلیب سرخ (ICRC) و سازمانهای غیردولتی، در جلسه مجمع عمومی که بهتازگی در نیویورک برگزار شده، شرکت کردند.

مِری وَرهِم، معاون مدیر بحران، درگیری و تسلیحات در دیدهبان حقوق بشر، گفت: دهها کشور نگرانیها و هشدارهای جدی خود را درمورد حذف کنترل انسان از سیستمهای تسلیحاتی ابراز کردند. در بحبوحه افزایش تمایل برای تنظیم سیستمهای تسلیحاتی خودمختار، کشورها باید متعهد شوند که امسال مذاکرات علنی درمورد معاهده رباتهای قاتل را آغاز کنند.

پیشرفتهای تکنولوژیکی و سرمایهگذاریهای نظامی، توسعه سریع سیستمهای تسلیحاتی خودکار را که بدون دخالت انسان عمل میکنند، تسریع میکنند.

این سیستمهای تسلیحاتی پس از فعال شدن، به نرمافزار متکی هستند و بهطور معمول از الگوریتمها، ورودی حسگرهایی مانند دوربینها، اشکال حرارتی و سایر دادهها برای شناسایی هدف استفاده میکنند. آنها پس از یافتن هدف بدون نیاز به تایید یا بررسی اپراتور انسانی، محموله خود را شلیک یا آزاد میکنند. این بدان معناست که یک ماشین بهجای انسان تعیین میکند که کجا، چه زمانی و در مقابل چه نیرویی اقدام کند.

در جلسه سازمان ملل، بسیاری از کشورها خواستار یک معاهده بینالمللی جدید برای رسیدگی به این نگرانیها و سایر نگرانیها شدند و بیشتر آنها از ممنوعیت شدید سیستمهای تسلیحاتی خودکار که غیرقابل پیشبینی هستند، حمایت کردند.

آنتونیو گوترش، دبیرکل سازمان ملل و میریانا اسپولجاریک اگر، رئیس کمیته بینالمللی صلیب سرخ، در افتتاحیه جلسه سازمان ملل درخواست خود را برای انعقاد یک سند الزامآور قانونی برای ممنوعیت این سلاحها تا سال ۲۰۲۶ تکرار کردند. آنها این سلاحها را از نظر سیاسی غیرقابل قبول و از نظر اخلاقی منفور توصیف کردند.

بیشتر بخوانید:

تصمیمگیری هوش مصنوعی آمریکایی برای جان مردم در جنگهای رژیم صهیونیستی

خیز گوگل برای توسعه هوش مصنوعی در زمینه تسلیحات و جاسوسی

دبیرکل سازمان ملل همچنین در گزارش خود برای سال ۲۰۲۵ درمورد حفاظت از غیرنظامیان که در ۲۲ می (اول خرداد) به شورای امنیت سازمان ملل ارائه خواهد شد، بر این درخواست تاکید کرده است.

بیش از ۱۲۰ کشور از درخواستها برای مذاکره درمورد معاهدهای که سیستمهای سلاحهای خودکار را ممنوع و تنظیم کند، حمایت میکنند. کمیته بینالمللی صلیب سرخ، گروههای حقوق بشری و بسیاری از دولتها میگویند که این معاهده باید سیستمهای سلاحهای خودکاری را که بدون کنترل معنادار انسانی کار میکنند یا مردم را هدف قرار میدهند، ممنوع کند. مقررات باید تضمین کنند که تمام سیستمهای سلاحهای خودکاری که تحت پوشش این ممنوعیتها نیستند، تنها با کنترل معنادار انسانی کار میکنند.

جلسه اخیر سازمان ملل چالشها و نگرانیهای جدی اخلاقی، حقوقی، بشردوستانه، امنیتی و فناوری ناشی از اجازه دادن به ماشینها برای گرفتن جان انسانها در میدان جنگ و همچنین در پلیس و سایر شرایط را بررسی کرد.

این جلسه سازمان ملل براساس قطعنامه مجمع عمومی درمورد سیستمهای سلاحهای خودمختار کُشنده که در ۲ دسامبر ۲۰۲۴ (۱۲ آذر ۱۴۰۳) با ۱۶۶ رای موافق، ۳ رای مخالف و ۱۵ رای ممتنع تصویب شده بود، تشکیل شد.

دیدهبان حقوق بشر و موسسه بینالمللی حقوق بشر دانشکده حقوق هاروارد، گزارش جامع جدیدی را با عنوان «خطری برای حقوق بشر» در این نشست توزیع کردند. این گزارش به تفصیل شرح میدهد که چگونه سیستمهای سلاحهای خودمختار، حقوق اساسی بشر را چه در زمان صلح و چه در زمان درگیریهای مسلحانه، ازجمله حق حیات، تجمع مسالمتآمیز، حریم خصوصی و جبران خسارت، و همچنین اصول کرامت و عدم تبعیض، نقض میکنند.

مری ورهم گفت: سیستمهای تسلیحاتی خودمختار همواره قوانین بینالمللی بشردوستانه و قوانین حقوق بشر را نقض میکنند و نگرانیهای اخلاقی زیادی را ایجاد میکنند. کشورها باید فراتر از ابراز نگرانیهای خود بروند و مذاکرات فوری برای معاهدهها را برای محافظت از بشریت در برابر این خطرات آغاز کنند.

آخرین اخبار جهان را از طریق این لینک پیگیری کنید.